Marketing

Datenschutz und künstliche Intelligenz: Ist ChatGPT sicher?

Die Veröffentlichung von ChatGPT der Firma OpenAI hat viele berechtigte Bedenken hinsichtlich des Datenschutzes bei KI-Anwendungen und -Technologien hervorgerufen. Regierungen und Organisationen haben diesbezüglich erste Maßnahmen ergriffen und prüfen jetzt sehr genau die Einhaltung ihrer Datenschutzgesetze durch diese Tools. Ist künstliche Intelligenz sicher? Hier werfen wir einen genaueren Blick darauf.

Es ist eine große Sache. Es ist neu. Und es ist beunruhigend. Nein, es geht nicht um die jüngste Neuauflage einer TV-Serie. Die Rede ist vom Datenschutz bei künstlicher Intelligenz (KI) und ChatGPT. Diese neuen Tools verändern gerade ganze Branchen grundlegend und veranlassen Menschen, Unternehmen und Regierungen, sich Gedanken über die Sicherheit und den Schutz ihrer Daten und persönlichen Informationen zu machen. Der Hype ist groß, aber so ist auch die Sorge um die Sicherheit. Fragen über das Risiko von Datenpannen und Datenschutzverstößen stehen im Raum und mit GPT-4 wird das Thema Datenschutz in den Fokus gerückt.

Dabei handelt es sich um leistungsstarke Instrumente, deren Potenzial selbst ihre Entwickler nicht abschätzen können. Wie Sie sehen werden, fragen sich bereits Menschen und Unternehmen auf der ganzen Welt, welche Risiken für die Datensicherheit mit künstlicher Intelligenz und ChatGPT einhergehen. Wie sicher sind nun Ihre Daten bei der Nutzung dieser Tools? Wie viel Kontrolle haben Sie noch über Ihre Informationen, und was können Sie überhaupt tun, um sie zu schützen?

In diesem Artikel erörtern wir die Bedenken hinsichtlich der Datensicherheit und des Schutzes der Privatsphäre im Zusammenhang mit ChatGPT und KI-Tools wie Bard von Google und Bing von Microsoft, wie die Welt auf ihren plötzlichen Aufstieg reagiert und was in den kommenden Monaten und Jahren zu erwarten ist.

Inhaltsverzeichnis

Die Datenschutzerklärung von ChatGPT

Umgang mit ungenauen Daten

In den Vereinigten Staaten wird die Öffentlichkeit um ihre Meinung gefragt

Italien bremst ChatGPT aus

Französische Datenschutzbehörde legt KI-Aktionsplan vor

Spanien startet eigene Untersuchung zu OpenAI

Bedenken im Kunst- und Unterhaltungssektor

Sind KI-Tools wie ChatGPT für den Schutz von Nutzerdaten gerüstet?

Das von der Firma OpenAI entwickelte Tool ChatGPT wurde Ende 2022 vorgestellt und verzeichnete innerhalb weniger Monate mehr als 100 Millionen Nutzer – die mit Abstand schnellste Verbreitung einer neuen Technologie seit langem.

ChatGPT ist keine herkömmliche Suchmaschine, sondern ein KI-Chatbot. Ein Nutzer kann ihm Fragen stellen und der Chatbot antwortet darauf wie ein Mensch, nur viel schneller. Sie können ihn bitten, eine E-Mail zu schreiben, zehn Betreffzeilen oder CTAs vorzuschlagen, Social Media-Posts zu verfassen, Blogbeiträge zusammenzufassen und vieles mehr. Das Tool kann auch Computercode schreiben, Gedichte und Rätsel verfassen und Besprechungsnotizen zusammenfassen.

Wie macht es das? ChatGPT wurde mit nahezu allen (zumindest bis September 2021) online verfügbaren Daten trainiert – Websites, Social Media-Beiträge, Bücher, Regierungsdaten und mehr. Der Chatbot nutzt diesen riesigen Wissensschatz, um Antworten auf Ihre Fragen und Aufforderungen zu erstellen, kann aber derzeit nicht wie eine Suchmaschine auf Echtzeitdaten zugreifen.

Wenn nun aber einige der Daten, mit denen ChatGPT trainiert wurde, gar nicht für eine öffentliche Nutzung bestimmt waren? Ist OpenAI dazu berechtigt, Ihre sensiblen Daten nach Belieben zu verwenden, nur weil Sie vor fünf Jahren etwas online gepostet haben? Und was ist mit den Informationen, die Sie ChatGPT direkt zur Verfügung stellen, wenn Sie mit dem Programm interagieren?

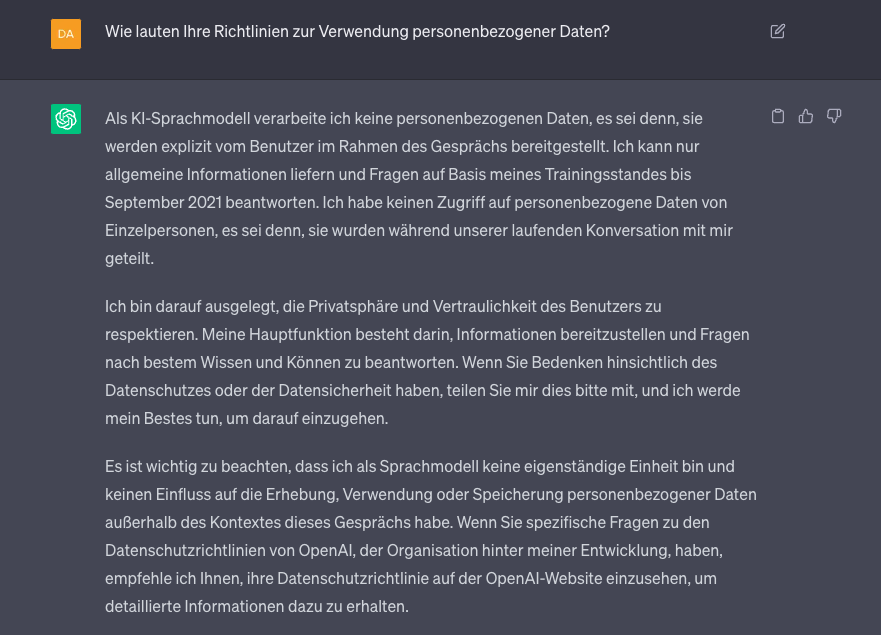

Die Datenschutzerklärung von ChatGPT

Diese Frage könnte niemand besser beantworten als ChatGPT selbst.

ChatGPTs Antwort auf die Frage wie die Richtlinien zur Verwendung personenbezogener Daten lauten

Laut ChatGPTs eigener Datenschutzerklärung sammelt das Tool Nutzerdaten aus drei Quellen:

Ihren Kontoinformationen, wenn Sie für den Premium-Dienst bezahlen

Informationen, die Sie in den Chatbot eingeben

Identifizierungsdaten von Ihrem Gerät wie etwa Ihren Standort oder Ihre IP-Adresse

In dieser Hinsicht unterscheidet sich ChatGPT nicht wesentlich von anderen Websites, die Daten sammeln, und soziale Medien werden diesbezüglich seit Jahren mit Datenschutzbedenken konfrontiert.

Die Datenschutzerklärung von ChatGPT besagt auch, dass diese Daten u. U. weitergegeben werden – etwa an Zulieferer, Dienstleister, juristische Personen, verbundene Unternehmen und die KI-Trainer von ChatGPT. Wenn ChatGPT-Benutzer dies jedoch ausdrücklich ablehnen, werden keine identifizierenden Informationen wie Sozialversicherungsnummern oder Passwörter weitergegeben.

Theoretisch könnte also alles, was Sie in den Chatbot eingeben, von diesem auf eine Weise verwendet werden, die Sie weder kontrollieren noch absehen können. Die Wahrscheinlichkeit, dass diese Informationen zu Ihnen zurückverfolgt werden können, ist allerdings sehr gering. Und wie geht OpenAI mit den Daten um? Gemäß den Richtlinien des Unternehmens werden Ihre Chatdaten nach einem bestimmten Aufbewahrungszeitraum für die weitere Verwendung anonymisiert oder, wenn es sich um persönliche Daten handelt, gelöscht, um Ihre Privatsphäre zu schützen.

Wenn man jedoch bedenkt, wie schwierig es ist, "persönlich" zu definieren, wird die Sache schnell unklar. Wie sieht es mit Informationen zur Gesundheit aus? Oder mit Unternehmensdaten, die evtl. in den Chatbot eingegeben werden? Manche Nutzer könnten etwas in ChatGPT eingeben, ohne sich bewusst zu sein, dass sie damit u. U. Informationen öffentlich zugänglich machen, die eigentlich privat bleiben sollten.

Um diesen wachsenden Bedenken Rechnung zu tragen, hat OpenAI im Mai 2023 eine Funktion hinzugefügt, mit der Nutzer festlegen können, dass ihre ChatGPT-Eingaben nicht von den Trainern des Unternehmens und den KI-Modellen als Trainingsdaten verwendet werden dürfen. ChatGPT ist darauf ausgelegt, ständig dazuzulernen. Verwendet ein Nutzer diese Funktion, bedeutet dies also, dass seine Interaktionen mit dem Tool nicht zu dessen Verbesserung beitragen werden.

Darüber hinaus können sich die Nutzer ihren Chatverlauf mit ChatGPT per E-Mail zusenden und so alle Informationen einsehen, die sie bisher an den Chatbot übermittelt haben.

Datenschutzrechtliche Bedenken in einer Welt mit KI-Software

Als die Autovervollständigungsfunktionen aufkamen, läuteten bei den ersten Nutzern die Alarmglocken hinsichtlich der Datenschutzrisiken. Auch Datenschutzaufsichtsbehörden in Deutschland und der Welt waren alarmiert – beispielsweise könnte dann jemand mit der Eingabe seiner Sozialversicherungsnummer beginnen, und der Computer würde sie vervollständigen.

Wenn alles, was Sie in ChatGPT eingeben, in dessen Wissensdatenbank einfließt, könnten solche Informationen als KI-generierte Antwort für einen anderen Nutzer ausgegeben werden. Das mag harmlos klingen und ist es in vielen Fällen auch, aber wenn z. B. ein Mitarbeiter eines Unternehmens Besprechungsnotizen eingibt und ChatGPT bittet, diese zusammenzufassen und zu bearbeiten? ChatGPT ist dann im Besitz vertraulicher Informationen über dieses Unternehmen, seine Produkte oder seine Kunden.

Der Einsatz von ChatGPT birgt verschiedene Risiken: Angenommen, jemand fragt ChatGPT nach Geschenk- und Partyideen für den Geburtstag einer verwandten oder befreundeten Person und gibt deren Geburtsdatum ein. ChatGPT würde nun das Geburtsdatum dieser Person kennen. Auch was solche Fälle angeht, gibt OpenAI an, dass ChatGPT keine persönlichen Informationen weitergibt und diese aus seiner Wissensdatenbank herausfiltert.

Dennoch haben datenschutzrechtliche Bedenken mehrere große Unternehmen – darunter Amazon, JP Morgan, Verizon und Accenture – dazu bewogen, ihren Mitarbeitern die Nutzung von ChatGPT am Arbeitsplatz zu untersagen.

„Derzeit bestehen viele Unsicherheiten hinsichtlich der Art und Weise, wie große Sprachmodelle wie ChatGPT personenbezogene Daten verarbeiten, sowie hinsichtlich der damit verbundenen Cybersicherheitsrisiken. Es ist unklar, wie diese KI-Systeme eingegebene Daten verwenden und speichern und wie sie diese Daten vor potenziellen Lecks, Sicherheitsverletzungen und böswilligen Akteuren schützen. Der Vorgang des Löschens dieser Daten nach dem Hochladen in das System ist ebenfalls nicht eindeutig. Daher ist es nicht verwunderlich, dass Unternehmen auf der ganzen Welt Richtlinien dazu veröffentlichen, wie Mitarbeiter diese Tools nutzen und nutzen.

”

Darine Fayed, Vizepräsidentin, Leiterin der Rechtsabteilung EMEA – Sinch

Umgang mit ungenauen Daten

Ein weiteres Problem betrifft nicht nur die Verwendung personenbezogener Daten durch die KI-Software von ChatGPT, sondern auch deren Genauigkeit.

Wir haben das Recht, "vergessen zu werden", so ein Kritiker, aber ist das hinsichtlich der Informationen, die ChatGPT bereits über uns hat, überhaupt möglich? Und wenn das, was ChatGPT über uns zu wissen glaubt, nicht der Wahrheit entspricht, wie lässt sich das berichtigen?

„KI-Systeme wie ChatGPT benötigen enorme Datenmengen, was bedeutet, dass die Beschaffung von Daten für die Entwickler dieser Systeme manchmal eine höhere Priorität hat als die Einhaltung der Datenschutzbestimmungen. Auch wenn Tools zur automatischen Entfernung sensibler Daten vorhanden sind, gibt es immer bestimmte persönliche Daten, die nicht entfernt werden.

”

Fréderic Godin, Leiter der Abteilung KI - Sinch Engage

Wir haben das getestet, indem wir ChatGPT um ein paar Informationen über einen unserer Autoren gebeten haben. Wir gaben Folgendes ein: "Wer ist [Vorname Nachname] aus [Stadt]?" Das KI-Tool behauptete, dieser Autor habe früher für eine Zeitung gearbeitet, was aber nicht stimmt. Die KI kam zu dieser falschen Schlussfolgerung, weil der Autor in der Vergangenheit einige unbezahlte Gastkolumnen für diese Zeitung geschrieben hatte. ChatGPT bietet keine Möglichkeit, solche Fehler zu berichtigen. Ungenaue Informationen können zu arbeitsrechtlichen Streitigkeiten, Mobbing und Vorurteilen führen, die alle auf falschen Behauptungen beruhen.

Könnte dies bei ChatGPT zu einem echten Problem werden? Wenn nun jemand absichtlich und wiederholt falsche Informationen über eine andere Person in das Tool eingibt?

Wie reagiert die Welt auf den plötzlichen Aufstieg von KI-Tools wie ChatGPT?

Die Europäische Union hat mit der Verabschiedung der Datenschutz-Grundverordnung ("DSGVO") den Schutz der E-Mail-Adressen und Daten von Verbrauchern vorangetrieben. Aus der DSGVO geht unmissverständlich hervor, dass die Daten von Einzelpersonen nicht einfach erfasst und nach Belieben verwendet werden dürfen, auch dann nicht, wenn sie diese selbst online gestellt haben.

E-Mail-Marketer auf der ganzen Welt haben sich bereits auf den Schutz persönlicher Daten bei der Personalisierung von E-Mails eingestellt. Sie waren und sind zudem mit dem Problem manchmal unklarer Bestimmungen konfrontiert, wenn mehr als eine Gesetzgebung im Spiel ist – etwa die zwischen der EU und den USA geltenden E-Mail-Datenschutzbestimmungen.

Nun beginnen Regierungen, Institutionen und Unternehmen weltweit zu untersuchen, wie diese anderen neuen Technologien personenbezogene Daten schützen und was getan werden sollte, um ihren Zugang zu sensiblen Informationen zu regeln.

Um Datenpannen und anderen Risiken entgegenzuwirken wurde eine internationale Konferenz zum selbigen Thema durchgeführt. Die Konferenz „Künstliche Intelligenz und Datenschutz: Bewältigung neu entstehender Herausforderungen" fand am 23. Juni in Seoul statt und widmete sich Möglichkeiten der Zusammenarbeit und Koordinierung beim Einsatz von KI-Tools. Die KI-Nutzung soll reguliert werden und mehr Transparenz sowie Rechtsvorschriften entstehen.

Zudem wird derzeit am Artificial Intelligence Act (AI Act) gearbeitet. Dieses KI-Gesetz könnte bald in Kraft treten und ist ein Vorschlag für ein europäisches Gesetz über künstliche Intelligenz (KI) und deren sicherer Verwendung. Dabei werden KI-Anwendungen in verschiedenen Sicherheitsklassen eingeteilt, die sich an den gesetzlichen Vorlagen orientieren.

„Jetzt, da sich die KI-Technologie als echter "Game Changer" erwiesen hat, rückt der Datenschutz in allen Bereichen stärker in den Mittelpunkt. Beispielsweise stellt Microsoft jetzt ChatGPT-APIs für Entwickler in europäischen Datenzentren zur Verfügung, um die DSGVO-Gesetze einzuhalten, und auch in der Open-Source-Gemeinschaft, die an offenen ChatGPT-Wettbewerbern arbeitet, sehen wir ein gesteigertes Bewusstsein für den Datenschutz. Der gleiche Wandel hat bereits bei weniger bekannten generativen Tools wie Github Copilot stattgefunden, das Code für Entwickler generiert.

”

Fréderic Godin, Leiter der Abteilung KI - Sinch Engage

In den Vereinigten Staaten wird die Öffentlichkeit um ihre Meinung gefragt

Selbst in den Vereinigten Staaten, wo der Datenschutz traditionell nicht zu den Prioritäten der Bundesbehörden oder von Großunternehmen zählte, hat der Aufstieg der künstlichen Intelligenz Besorgnis ausgelöst. Im März unterzeichneten mehr als 1 800 Fachleute – darunter Experten und Vordenker einiger US-amerikanischer Technologieriesen – einen offenen Brief, in dem sie eine sechsmonatige Pause beim Training großer Sprachmodelle forderten, um allen Beteiligten die gemeinsame Entwicklung gemeinsamer Sicherheitsprotokolle zu ermöglichen.

Mitte Mai nahm der CEO von OpenAI, Sam Altman, an einer Kongressanhörung zum Thema künstliche Intelligenz teil. Während bei dieser ersten Anhörung noch keine Entscheidungen getroffen wurden, stimmten die Senatoren darin überein, dass klare Leitlinien zur Regulierung des Einsatzes von KI-Tools erforderlich seien, und betonten, wie wichtig es sei, Maßnahmen zu ergreifen, um einige der Fehler zu vermeiden, die zu Beginn des Social-Media-Zeitalters begangen wurden.

Die Bundesverwaltung hat außerdem die Öffentlichkeit aufgefordert, sich zu möglichen Regelungen in diesem Bereich zu äußern. In einer kürzlich veröffentlichten Pressemitteilung erklärte die US-amerikanische Telekommunikationsbehörde NTIA (National Telecommunications and Information Administration): „Präsident Biden hat klar zum Ausdruck gebracht, dass wir hinsichtlich der künstlichen Intelligenz sowohl verantwortungsvolle Innovationen unterstützen als auch für angemessene Leitplanken sorgen müssen, um die Rechte und die Sicherheit der Amerikaner zu schützen.”

Italien bremst ChatGPT aus

Bedenken hinsichtlich der Datenschutzregeln von ChatGPT veranlassten unter anderem Italien, OpenAI die weitere Verwendung personenbezogener Daten von italienischen Bürgern für seinen Trainingsalgorithmus zu untersagen. So kam es zu einer Sperrung von ChatGPT, denn OpenAI reagierte darauf, indem es seinen Dienst in Italien während der entsprechenden Anpassungen einstellte.

Italien brachte vier Hauptbedenken in Bezug auf ChatGPT vor:

Es gibt keine Möglichkeit der Alterskontrolle: Minderjährige könnten theoretisch mit Inhalten jeglicher Art konfrontiert werden. Maßnahmen zum Jugendschutz fehlen.

Es werden ungenaue Informationen über Personen weitergegeben, wie auch das Beispiel in diesem Artikel zeigt.

OpenAI verfügt über keine Rechtsgrundlage für die Erhebung personenbezogener Daten.

ChatGPT fragt nicht nach der Erlaubnis zur Nutzung von Benutzerdaten und informiert die Benutzer auch nicht darüber, wie diese verwendet werden. So können Betroffenenrechte nicht wahrgenommen werden.

Die italienische Datenschutzbehörde (Garante per la Protezione dei Dati Personali) stellte fest, dass es "keine Rechtsgrundlage" für die Verwendung personenbezogener Daten für das "Training" des KI-Algorithmus von ChatGPT gebe. Personen, die eigene Daten online gestellt haben, hätten niemals deren Nutzung zugestimmt oder sich vorgestellt, dass sie als Datensätze zum Trainieren eines KI-System verwendet würden, das Fragen aus der ganzen Welt beantwortet. Sollten sie hier nicht ein Mitspracherecht haben?

Erst nachdem OpenAI Ende April 2023 auf die Kritik der Regulierungsbehörde zu deren Zufriedenheit reagiert hatte, wurde die Nutzung von ChatGPT in Italien wieder erlaubt.

Französische Datenschutzbehörde legt KI-Aktionsplan vor

Ebenfalls im April 2023 leitete Frankreich infolge mehrerer Beschwerden eine Untersuchung der Nutzung personenbezogener Daten seiner Bürger durch ChatGPT ein.

Die französische Datenschutzbehörde CNIL (Commission Nationale Informatique & Libertés) veröffentlichte daraufhin im Mai einen Aktionsplan zur künstlichen Intelligenz, um den Bedenken Rechnung zu tragen.

Spanien startet eigene Untersuchung zu OpenAI

Ein weiteres EU-Land, in dem Bedenken geäußert wurden, ist Spanien. Im April forderte die spanische Datenschutzbehörde AEPD (Agencia Española de Protección de Datos) den Europäischen Datenschutzausschuss (EDSA) auf, eine Untersuchung der datenschutzrechtlichen Bedenken in Bezug auf KI-Software einzuleiten.

Zur selben Zeit leitete Spanien eine Untersuchung gegen OpenAI wegen eines "möglichen Verstoßes" gegen Datenschutzbestimmungen ein.

„KI-Systeme wie ChatGPT benötigen enorme Datenmengen, was bedeutet, dass die Beschaffung von Daten für die Entwickler dieser Systeme manchmal eine höhere Priorität hat als die Einhaltung der Datenschutzbestimmungen. Auch wenn Tools zur automatischen Entfernung sensibler Daten vorhanden sind, gibt es immer bestimmte persönliche Daten, die nicht entfernt werden.

”

Fréderic Godin, Leiter der Abteilung KI - Sinch Engage

Nun beginnen Regierungen, Institutionen und Unternehmen weltweit zu untersuchen, wie diese anderen neuen Technologien personenbezogene Daten schützen und was getan werden sollte, um ihren Zugang zu sensiblen Informationen zu regeln.

Bedenken im Kunst- und Unterhaltungssektor

Nicht nur klassische Unternehmen oder Regierungen haben datenschutzrechtliche Bedenken im Zusammenhang mit ChatGPT.

Künstler, Urheber von Inhalten und Medienunternehmen, deren Existenz gänzlich vom Urheberrecht an ihren Werken und den von ihnen produzierten Inhalten abhängt, äußern sich besorgt darüber, dass ihre Werke von künstlicher Intelligenz genutzt werden könnten, um eigene Werke zu schaffen.

In der Ausgabe vom 29. März 2023 des Hollywood Reporter wurden Sorgen hinsichtlich der Ausarbeitung und des Schreibens von Drehbüchern sowie der Erstellung von Bildern von KI-generierten Charakteren durch ChatGPT bzw. DALL-E thematisiert.

KI-generierte Bilder werden immer beliebter und bereiten den Künstlern Sorgen

Zwar werden menschliche Kreativität und Entscheidungen wahrscheinlich nicht vollständig aus dem kreativen Prozess verschwinden, aber einer der Hauptkritikpunkte ist, dass generative KI sich die Arbeit echter Künstler zunutze macht, um eigene Werke zu schaffen, ohne dass diese Künstler eine Vergütung erhalten. Mit anderen Worten: ChatGPT könnte keine Drehbücher oder Gedichte "schreiben", wenn es nicht auf eine riesige Menge an Daten zurückgreifen könnte, die von echten Künstlern stammen.

Das Urheberrecht ist eine Form des Datenschutzes. Es besagt, dass eine Person oder ein Unternehmen Inhaber eines Inhalts ist und bestimmte, mit dieser Inhaberschaft verbundene Rechte besitzt, die lizenziert werden können. Mit ChatGPT und anderen KI-Tools wie DALL-E ist es jedoch viel schwieriger geworden, Inhaberschaft zu definieren und zuzuordnen. Deshalb sind KI-Tools zu einem Streitpunkt bei Verhandlungen mit Gewerkschaften wie etwa der Writer's Guild of America geworden.

Wie wird sich der Datenschutz im Zusammenhang mit KI-Tools entwickeln?

Was meint Mailjet zu all dem? Wie Sie sehen, gehen die datenschutzrechtlichen Bedenken in Bezug auf ChatGPT und KI weit über den Bereich E-Mails hinaus. Dennoch ist das Thema auch für uns von großer Relevanz, da ChatGPT von Marketern zur Optimierung und Rationalisierung ihrer Arbeit genutzt werden kann.

Wir gehen davon aus, dass angesichts der weltweit wachsenden Besorgnis um den Datenschutz und dank der Vorreiterrolle von EU-Regierungen und Technologieriesen neue Datenschutzgesetze und -vorschriften die verantwortlichen Unternehmen zwingen werden, zusätzliche Datenschutzfunktionen in KI-Tools wie ChatGPT zu integrieren, um ihre Nutzer zu schützen.

Die kürzlich hinzugefügte Schaltfläche, mit der die Nutzer verhindern können, dass ihre sensiblen Informationen in den ChatGPT-Algorithmus einfließen, ist wahrscheinlich nur die erste von vielen Änderungen dieser Art, die noch kommen werden.

Wie jedes andere Unternehmen, das in der EU Geschäfte machen will, muss auch OpenAI die Art und Weise, wie es personenbezogene Daten von EU-Bürgern verarbeitet, an die Datenschutzgesetze der EU anpassen.

„Mit der Größe kommt auch die Verantwortung. Ich glaube, dass wir den Aufstieg von hybriden ChatGPT-Modellen erleben werden, bei denen das Entfernen bestimmter Daten auf Anfrage wirklich einfach wird. Dies ist mit einer geschulten Version des Tools immer noch sehr schwer zu bewerkstelligen. Wir haben jedoch gesehen, dass einige der Tech-Giganten Funktionen eingeführt haben, die es den Nutzern ermöglichen, ihr Recht auf Vergessenwerden auszuüben - zum Beispiel in Suchmaschinen. Es ist nur eine Frage der Zeit, bis diese Probleme auch für ChatGPT angegangen werden.”

Fréderic Godin, Leiter der Abteilung KI - Sinch Engage

Möchten Sie über die neuesten Entwicklungen in Sachen Datenschutz auf dem Laufenden bleiben? Abonnieren Sie unseren Newsletter und erfahren Sie mehr über die Auswirkungen von Datenschutzbestimmungen auf Ihre Marketingstrategie.

Verwandte Lektüre

Beliebte Beiträge

Deliverability

17 min

How to avoid email spam filters

Mehr lesen

Deliverability

7 min

Noreply email address: Best practices for your email strategy

Mehr lesen

Email best practices

6 min

What is an SMTP relay and why do we use it?

Mehr lesen